mrjob er en Python-modul som hjelper deg skrive og kjøre Hadoop Streaming jobber.

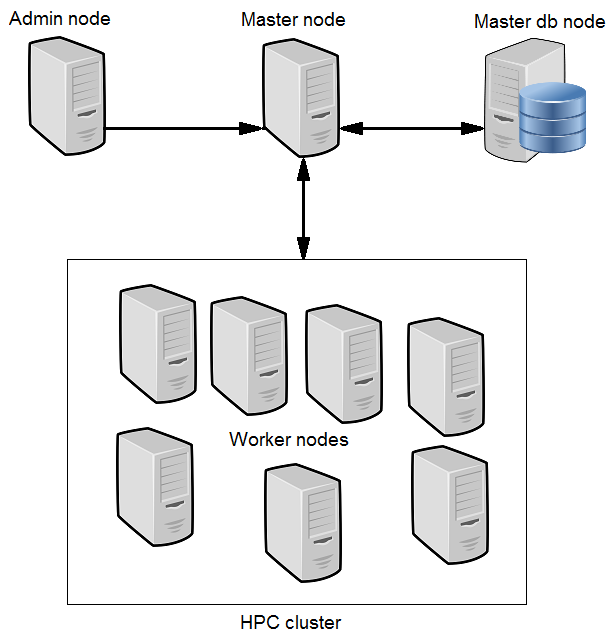

mrjob støtter fullt Amazons Elastic MapReduce (EPJ) tjeneste, som lar deg kjøpe tid på en Hadoop cluster på timebasis. Det fungerer også med din egen Hadoop cluster.

Installasjon:

python setup.py installere

Sette opp EPJ på Amazon

& Nbsp; * skape en Amazon Web Services konto: http://aws.amazon.com/

& Nbsp; * registrere deg for Elastic MapReduce: http://aws.amazon.com/elasticmapreduce/

& Nbsp; * Få din tilgang og hemmelige nøkler (gå til http://aws.amazon.com/account/ og klikk på "sikkerhetsinformasjon") og sette miljøvariabler $ AWS_ACCESS_KEY_ID og $ AWS_SECRET_ACCESS_KEY tilsvar

Prøv det ut!

# Lokalt

python mrjob / eksempler / mr_word_freq_count.py README.md> teller

# På EPJ

python mrjob / eksempler / mr_word_freq_count.py README.md -r EPJ> teller

# På Hadoop cluster

python mrjob / eksempler / mr_word_freq_count.py README.md -r Hadoop> teller

Advanced Configuration

Å kjøre i andre AWS regioner, laste opp din kilde treet, kjøre make, og bruke andre avanserte mrjob funksjoner, må du sette opp mrjob.conf. mrjob ser for sin conf fil i:

& Nbsp; * ~ / .mrjob

& Nbsp; * mrjob.conf hvor som helst i din $ PYTHONPATH

& Nbsp; * /etc/mrjob.conf

Se mrjob.conf.example for mer informasjon

Egenskaper .

- Kjør jobber på EPJ, din egen Hadoop cluster, eller lokalt (for testing).

- Skriv flertrinns jobber (ett kart-redusere trinn trekkes inn i den neste)

- Duplicate produksjonsmiljøet inne Hadoop

- Last opp din kilde treet og legge den i din jobb er $ PYTHONPATH

- Kjør make og andre oppsetts scripts

- Sett miljøvariabler (f.eks $ TZ)

- Du kan enkelt installere python pakker fra tarballs (EPJ only)

- Oppsett håndteres transparent av mrjob.conf config fil

- Automatisk tolke feillogger fra EPJ

- SSH tunnel til Hadoop jobb tracker på EPJ

- Minimal installasjon

- Hvis du vil kjøre på EPJ, satt $ AWS_ACCESS_KEY_ID og $ AWS_SECRET_ACCESS_KEY

- Hvis du vil kjøre på din Hadoop cluster, satt $ HADOOP_HOME

Krav :

- Python

Kommentarer ikke funnet